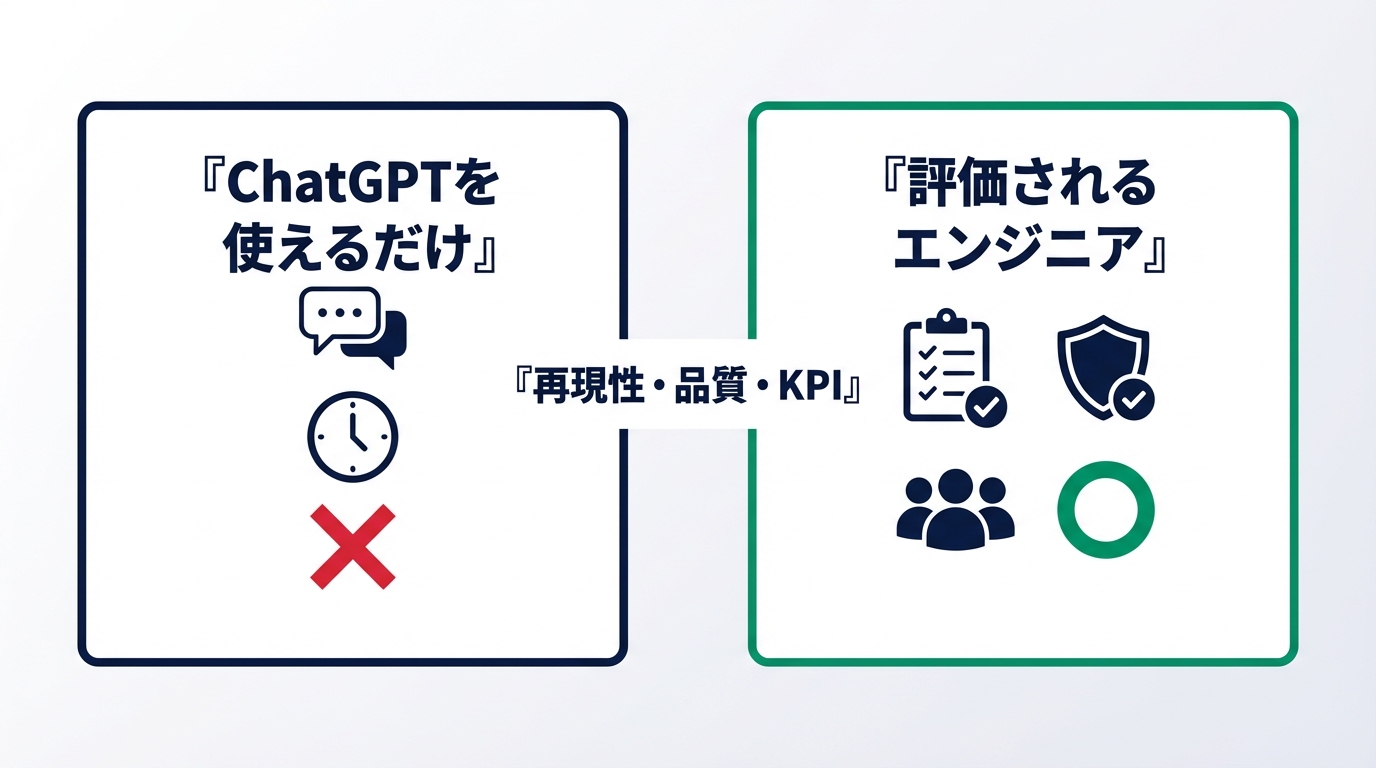

「ChatGPTを使えます」は、いまやエンジニアの“差別化要因”になりにくくなっています。理由は単純で、生成AIの利用が広がるほど、企業は“ツールを触れるか”ではなく“成果を安定して出せるか(再現性)”で評価せざるを得ないからです。実際、AI人材の採用は増え続けており、LinkedInのレポートでは「AIタレント採用は全採用に対して相対的に30%増(昨秋以降)」と示されています。[出典:LinkedIn Work Change Report(PDF)]

また、世界経済フォーラムは2025〜2030年にかけて、労働者のスキルのうち平均39%が変化・陳腐化するとし、継続的な学習と役割変化への適応が前提になると示しています。[出典:WEF The Future of Jobs Report 2025(Digest)]

セクション1:評価されない本質は「ChatGPTが使える」ではなく「成果の再現性が説明できない」こと

まず押さえておきたいのは、企業がエンジニアを評価するときの物差しが「作業量」から「価値の再現性」に寄っている点です。ChatGPTは、文章作成・要約・コード補助・テスト観点の抽出など、幅広いタスクで即効性があります。しかし、誰もが同じ道具を持つと、評価軸は自然に次の問いへ移ります。

- その出力は要件に合っているか

- 境界条件や例外を含めて品質を担保できるか

- 運用・保守・セキュリティまで含めて事故らない形にできるか

- チーム開発の文脈で再現可能なプロセスに落とせるか

つまり「ChatGPTを使って速い」だけでは、評価者が最も知りたい“安定して任せられるか”に答えられません。経済産業省も、生成AI時代のDX推進人材に求められる力として「問いを立てる力」「仮説を立て・検証する力」に加え、「評価する・選択する力」が重要だと整理しています。[出典:経産省「生成AI時代のDX推進に必要な人材・スキルの考え方2024(概要PDF)」]

なぜ「使える」だけだと評価が上がらないのか

結論は、成果が個人芸で終わり、組織にスケールしないからです。ChatGPTの活用が“自分の手元の時短”に留まっていると、チームの生産性や品質にどう寄与したかが見えません。評価者(EM/PM/テックリード)が見たいのは、次のような「成果の形」です。

- リードタイム短縮(例:要件確認→実装→レビュー→リリースまでの時間)

- 品質改善(例:手戻り件数、重大バグ、レビュー指摘の再発率)

- 運用安定(例:障害件数、MTTR、SLO達成率)

- ナレッジ共有(例:テンプレ、ガイド、テスト観点集、設計メモ)

ChatGPTはこれらを“手助け”できますが、達成するのは結局「設計・判断・検証・運用」です。ここが弱いまま「生成して貼った」だけだと、むしろレビュー負荷が上がり、品質事故のリスクが増えるため評価が伸びません。

実例:同じ「ChatGPT活用」でも評価が割れたケース

ケースA(評価が上がらない):バックエンドの実装でChatGPTにコードを生成させ、動作確認も最低限でPRを量産。短期的にコミットは増えたが、境界条件の漏れ・例外処理不足が多発し、レビュー指摘が増加。リリース後の不具合対応で結局リードタイムが伸び、チームの負荷が高まった。

ケースB(評価が上がる):同じくChatGPTで下書きを作るが、先に「要件・禁止事項・性能要件・セキュリティ観点」を箇条書きにして入力。生成後は“採用基準”に沿って差分レビュー(境界条件/エラー設計/ログ/テスト)を実施し、テスト観点集をチームに共有。結果としてレビュー指摘の再発率が下がり、チームのリリースが安定した。(※個人が特定されないよう一部改変)

同じ「ChatGPTを使う」でも、Aは“作業者の加速”で止まり、Bは“成果の再現性”に落とせています。評価がつくのは後者です。

KPI提案:「使える」を「評価される」に変える最小セット

今日から変えられるKPIを、過剰に難しくしない形で3つに絞ります。

- 品質KPI:レビュー指摘の再発率を記録(同種指摘が次PRで出たら1カウント)。まずは「再発ゼロ」を1か月目標にする。

- 生産性KPI:ChatGPT活用で短縮できた時間を週次で合計(例:要約30分、テスト観点20分、下書き40分)。ただし“短縮分で何を改善したか”も1行で残す。

- 共有KPI:月2本、チームに残る成果物を作る(例:プロンプト+レビュー観点テンプレ、テスト観点チェックリスト、ADR/設計メモ)。

ポイントは、ChatGPTの操作スキルではなく、成果の再現性(品質・速度・共有)を数字と成果物で示すことです。これができると「使えるだけ」から「任せられる人」へ評価が変わります。

セクション2:評価が落ちる「ChatGPT活用の落とし穴」――鵜呑み・ブラックボックス化・責任放棄

ChatGPTを使っているのに評価が伸びない(むしろ下がる)ケースの多くは、「使っていること」そのものではなく、使い方がチーム開発の前提と噛み合っていないことに起因します。生成AIは強力ですが、出力の正しさ・一貫性・最新性が常に保証されるわけではありません。だからこそ、現場で評価されるのは“生成できる人”ではなく、“生成を安全に製品へ落とし込める人”です。

経済産業省が整理する「問いを立てる力」「仮説を立て・検証する力」「評価する・選択する力」は、生成AIを使うほど重要性が増します。生成AIが答えを返してくれるからこそ、答えを採用する前に「評価し、選択し、責任を持つ」プロセスが必須になるためです。[出典:経産省「生成AI時代のDX推進に必要な人材・スキルの考え方2024(概要PDF)」]

落とし穴1:出力の“鵜呑み”がレビュー負荷と障害を増やす

最も典型的な失敗は、ChatGPTの出力を“それっぽいから”採用してしまうことです。生成AIは、もっともらしい文章やコードを出すのが得意です。しかし「もっともらしい=正しい」ではありません。実務で致命的になりやすいのは、次のような抜け漏れです。

- 境界条件の欠落:空配列、null、上限・下限、タイムゾーン、桁あふれ、並行処理など

- 例外設計の甘さ:リトライ方針、リソース解放、エラーの握りつぶし、ログ不足

- セキュリティ観点の欠落:入力検証、権限、PII、SQL/プロンプトインジェクション、秘密情報の扱い

- 性能要件の見落とし:N+1、重い正規表現、不要なI/O、キャッシュ戦略なし

“鵜呑み”が怖いのは、本人が速くなっている感覚がある一方で、チームとしてはレビューで拾う作業が増え、運用での事故確率が上がることです。結果として「この人のPRは確認コストが高い」「任せると後で燃える」という印象がつき、評価が伸びません。

落とし穴2:ブラックボックス化で「なぜそうしたか」を説明できない

ChatGPTの出力を起点に実装すると、意思決定が“AIの提案”に寄りやすくなります。ここで起きる問題は、実装自体よりも「説明責任の欠落」です。エンジニアは、仕様・設計・品質・運用について、関係者に説明し合意を取る仕事でもあります。ところが「ChatGPTがこう言ったので」では、説明になりません。

評価者が見ているのは、コードの行数よりも「意思決定の質」と「再現性」です。ブラックボックス化すると、次の場面で詰みます。

- 障害対応で原因究明が遅れる(“なぜその実装か”が辿れない)

- レビューで設計意図が伝わらず、やり直しが増える

- 仕様変更時に影響範囲が読めず、保守性が落ちる

- 引き継ぎが困難になり、チームに負債を残す

逆に評価される人は、ChatGPTを使っても「設計意図」「採用しなかった案」「リスクとガードレール」を言語化できます。つまりAIは“下書き生成”であり、最終的な意思決定は人間が責任を持って行っている状態です。

落とし穴3:責任放棄に見える(セキュリティ・品質・法務の線引きが曖昧)

生成AI活用は、便利な一方で「責任の所在」を曖昧にしがちです。たとえば、以下のような振る舞いは、本人に悪意がなくても“責任放棄”に見えます。

- 機密情報や顧客データの扱いに無頓着(入力して良いデータの線引きがない)

- 依存ライブラリやライセンス確認をしない(出力コードをそのまま取り込む)

- セキュリティ上の論点をレビューに丸投げ(脅威モデル不在)

- テストや監視を後回しにしてリリースを急ぐ(運用で回収すればいい発想)

生成AI時代ほど、信頼できるエンジニアの条件は「速さ」だけではなく「安全に速い」です。評価者は、速度と同じくらい“事故らない設計・運用”を重視します。

実例:ChatGPT活用が裏目に出たチームと、うまく回ったチーム

裏目に出た例:個人最適でプロンプトを回し、PRを高速で量産。結果として、テスト観点が薄く、境界条件漏れが多発。レビューで毎回同じ指摘が繰り返され、チームのスループットは逆に低下。本人は「AIで速くなっている」と感じているが、チームからは「確認コストが高い」と見られて評価が伸びない。

うまく回った例:チームで「AIを使う前提のルール」を決めた。具体的には、(1)入力してはいけない情報、(2)採用前の検証チェック(要件一致/境界条件/セキュリティ)、(3)生成物の扱い(下書き・参考・最終決定は人間)を明文化。さらに、テスト観点テンプレとレビュー観点を共有資産化し、誰が使っても品質が落ちない形にした。結果として“AI活用がチームにスケール”し、評価されるのは「ルールを作って回した人」になった。(※個人が特定されないよう一部改変)

KPI提案:落とし穴を回避し「任せられる人」になるための3KPI

ここでは、現場で運用しやすいように、KPIを3つに絞ります。ポイントは、ChatGPTの使用回数ではなく“品質と説明責任”が上がっていることを示す指標です。

- KPI1:再発指摘率

レビューで同種の指摘が繰り返された回数を記録する(例外処理、命名、テスト不足などカテゴリ分け)。月次で「再発ゼロのカテゴリ」を増やす。 - KPI2:検証チェック適用率

PRごとに「要件一致/境界条件/セキュリティ」の3点チェックを実施したかを自己申告ではなく、PRテンプレにチェック欄を置く。適用率100%を目標。 - KPI3:説明資産の蓄積

月2本、設計意図が残る成果物を作る(ADR、設計メモ、テスト観点集、監視項目、プロンプト+レビュー観点テンプレ)。“誰でも再現できる形”になっているかを重視。

この3つを回し始めると、「ChatGPTを使える」から「ChatGPTを使っても品質と説明責任を落とさず成果を出せる」に評価が変わります。つまり、評価されない理由はツールではなく、ツール利用が“責任あるプロセス”に統合されていないことです。

セクション3:評価されるエンジニアは、ChatGPTを「作業の置き換え」ではなく「成果の拡張」に使っている

評価される人の共通点は、ChatGPTを“自分の作業を速くする道具”で止めず、成果が増える場所(上流・設計・評価・運用)に使い直している点です。生成AIが普及するほど、単純な作業の速度は「前提条件」になりやすく、差がつくのは「何を速くした結果、何が良くなったか」を説明できる人です。経済産業省が示すように、生成AI時代に求められるのは、問いを立て、仮説検証し、評価して選択する力です。[出典:経産省「生成AI時代のDX推進に必要な人材・スキルの考え方2024(概要PDF)」]

このセクションでは、評価されるエンジニアがやっている“使い方の型”を、実務で再現できるようにフローとテンプレに落とします。重要なのは「プロンプトの巧さ」ではなく、チームの成果が安定するプロセスを作ることです。

レベル1:実装スピードだけで勝負しない(上流の“定義”を作る)

ChatGPTを使う前に、評価される人は「要件を定義し直す」作業を挟みます。なぜなら、要件が曖昧なまま生成すると、出力のブレが増え、手戻りが増えるからです。逆に、要件が固いほど、ChatGPTは強力な“下書き生成機”になります。

型:生成前に、以下の4点だけを箇条書きで固定します。

- 目的:この変更で何を改善するか(例:リードタイム短縮、障害率低下、問い合わせ削減)

- 制約:守るべきルール(例:互換性、性能、セキュリティ、データ取り扱い)

- 受け入れ条件:OKの定義(例:ユースケース、境界条件、エラー仕様)

- 非目標:今回やらないこと(スコープを閉じる)

この“定義”があるだけで、生成物の品質が安定し、レビュー負荷が下がります。結果として「速い」だけではなく「事故らない」「チームの時間を守る」という評価に繋がります。

テンプレ:生成前の“定義”を作るプロンプト(コピペ用)

以下は、実装前の整理に使えるテンプレです。プロンプトの目的は「良いコードを出すこと」ではなく、良い意思決定の材料を出すことです。

目的:〇〇を改善したい(KPI:〇〇) 背景:現状の問題は〇〇 制約:〇〇(セキュリティ/互換性/性能/運用) 受け入れ条件:〇〇(具体例:入力A→出力B、例外時は〇〇) 非目標:今回は〇〇はしない 相談したいこと: 1) 設計案を2〜3個(メリデメ付き) 2) 想定される落とし穴(境界条件/運用/セキュリティ) 3) 最低限必要なテスト観点

レベル2:設計と判断を“説明可能”にする(ブラックボックスを消す)

評価されるエンジニアは、ChatGPTの提案をそのまま採用しません。必ず「採用理由」と「採用しなかった案」を残します。ここで効くのが、軽量なADR(Architecture Decision Record)です。大げさなドキュメントではなく、3〜5行の意思決定ログで十分です。

なぜADRが効くか:評価者が見たいのは「考えた痕跡」と「判断の筋の良さ」です。ADRがあると、障害時・仕様変更時・引き継ぎ時に強く、チームの時間を節約します。これは“自分の成果”以上に評価されやすいポイントです。

テンプレ:超軽量ADR(コピペ用)

決定:〇〇方式を採用する 理由:〇〇(目的KPIに効く/制約を満たす) 代替案:A案(却下理由:〇〇)、B案(却下理由:〇〇) リスク:〇〇(発生条件:〇〇) ガードレール:〇〇(テスト/監視/入力制限/ロールバック)

レベル3:評価される人は“テスト観点”を先に作る(品質がブレない)

「ChatGPTを使えるのに評価が伸びない」人は、実装を先にしてテストを後にしがちです。逆に評価される人は、テスト観点を先に作ってから生成や実装に入ります。理由は、テスト観点が“受け入れ条件の翻訳”であり、ここが固いほど生成物の品質が安定するからです。

ChatGPTは、テスト観点の網羅性を高める用途で特に強いです。ただし重要なのは、出てきた観点をそのまま使うのではなく、自分のシステムの制約(データ、負荷、権限、外部API)に合わせて取捨選択できることです。

テンプレ:テスト観点を作るプロンプト(コピペ用)

対象機能:〇〇 期待する振る舞い:〇〇 入力のパターン:正常/境界/異常(具体例:〇〇) 制約:性能(〇〇ms以内)、権限(〇〇ロールのみ)、データ(PIIを扱う/扱わない) 依存:外部API(タイムアウト、リトライ、レート制限) 依頼:この機能のテスト観点を「正常系・境界条件・異常系・セキュリティ・性能・運用」に分けて列挙し、特に抜けやすい観点を強調して。

レベル4:運用・監視まで含めて“任せられる”を作る(ここで評価が跳ねる)

ChatGPT活用が当たり前になるほど、差がつくのは「運用」側です。リリース後に事故が起きないように、ログ・メトリクス・アラート・ロールバックを含めて設計できる人は、チームの信用を一気に取りにいけます。これは、単に実装が速い人よりも、評価の上振れが大きい領域です。

ポイント:運用を“頑張り”で回すのではなく、最低限のガードレールをテンプレ化してチームに残します。ChatGPTは、監視項目の洗い出しや障害時の切り分け手順(Runbook)の下書きで効果が出やすいです。

テンプレ:監視・運用チェックリスト(コピペ用)

- ログ:成功/失敗の識別ができるか(エラーコード、相関ID、入力の要約)

- メトリクス:失敗率、レイテンシ、スループット、外部依存のタイムアウト

- アラート:しきい値は妥当か(誤検知/見逃しを避ける)

- ロールバック:戻し方が明文化されているか(手順、影響範囲)

- セキュリティ:権限、入力検証、秘密情報、監査ログ

実例:評価される人は「個人の時短」を「チームの資産」に変える

あるチームで、ChatGPT活用が広がった結果、最初は各自が好き勝手に使い、PRの品質がばらつきました。そこで評価されるエンジニアは、(1)生成前の定義テンプレ、(2)超軽量ADR、(3)テスト観点プロンプト、(4)運用チェックリストを整備し、PRテンプレに組み込みました。するとレビューの論点が揃い、再発指摘が減り、オンボーディングも楽になりました。本人が速いだけでなく、チームの速度と品質が安定したため、役割が広がり評価も上がった(※個人が特定されないよう一部改変)。

KPI提案:ChatGPT活用を“評価”に直結させるKPI設計

最後に、セクション3の内容を「評価される形」に変えるKPIを置きます。KPIは多いほど続きません。最小限の3つで回します。

- KPI1:再発指摘率(品質):同種のレビュー指摘が翌PRで出た回数を月次で減らす(カテゴリ別に可視化)。

- KPI2:意思決定ログ率(説明責任):重要PRのうち、ADR(3〜5行)が残っている割合。まずは50%→80%を目標。

- KPI3:共有資産数(スケール):月2本、テンプレやチェックリストをチームに残す(再利用可能な形が条件)。

ここまでできると、「ChatGPTを使える」ではなく「ChatGPTを使って成果を拡張し、チームの再現性を上げる人」として評価されます。次のセクションでは、ここまでの型を“現場導入”するために、チーム・上司・レビュー文化の中で摩擦を起こさず浸透させる方法(合意形成・ルール作り・NG例)を扱います。

セクション4:チームでChatGPT活用を標準化できないと評価は伸びない――「合意形成」「ルール化」「摩擦ゼロ導入」

ChatGPTを使えるエンジニアが評価されない最大の理由は、個人の時短が“チームの成果”に接続されていないからです。個人の生産性が上がっても、レビュー負荷が増えたり、品質がばらついたり、セキュリティリスクが上がったりすると、組織としてはマイナスになります。逆に、評価されるエンジニアは「自分が使う」から一歩進んで、チームが安全に使える状態(標準化)を作ります。

ここで重要なのは、立派な規程を作ることではありません。むしろ、現場ではルールが重いほど守られず、形骸化します。狙うべきは、“守られる最小ルール”と、“守るほど楽になる仕組み”です。ChatGPT活用の標準化は、技術導入ではなく、プロセス設計の仕事になります。

なぜ標準化できないと評価が伸びないのか

チーム開発では、評価者(EM/PM/Tech Lead)が見ているのは「個人の速さ」より、次の3点です。

- 品質が安定しているか:誰が書いても一定の品質になるか(属人化していないか)

- 説明責任を果たせるか:意思決定の理由が残り、障害時に追えるか

- チームの速度が上がるか:レビュー・運用・オンボーディングのコストが下がるか

個人のChatGPT活用が標準化されていないと、PRごとに品質が変動し、「この人のPRは怖い」「確認コストが高い」という評価になりがちです。逆に、標準化できる人は“チームの再現性”を上げるため、役割が広がりやすく、評価にも直結します。

導入の鉄則:いきなり“禁止/義務化”しない

ChatGPT活用の話をすると、現場では次のような摩擦が起きやすいです。

- 「生成AIは危険だから禁止すべき」派 vs 「自由に使わせて」派の対立

- 「プロンプト共有は恥ずかしい」などの心理抵抗

- 「結局レビューが増えるだけ」という疲労

- 「情報漏えいが怖い」から話が止まる

評価される導入は、ここで正論をぶつけて勝つことではありません。摩擦を減らし、合意できる範囲から始めることです。おすすめは、次の順番です。

- Step1:“事故りにくい用途”だけ許可して小さく始める(要約、テスト観点草案、レビュー観点の洗い出しなど)

- Step2:最小ルール(禁止事項+採用前チェック)だけを合意する

- Step3:守るほど楽になる仕組み(PRテンプレ、チェック欄、共有ページ)に組み込む

- Step4:数値で効果検証し、徐々に範囲を広げる

最小ルールの作り方:3つだけでいい

標準化が成功するチームは、ルールを増やしません。最初は次の3つだけで十分です。

- ルール1:入力してはいけない情報を明確化

例:顧客情報、個人情報、機密仕様、社外秘コード、認証情報、脆弱性の詳細など - ルール2:採用前チェックを固定(3点)

要件一致/境界条件/セキュリティ(この3点をPRテンプレで確認) - ルール3:最終責任は人間(AIは下書き)

「AIが言ったから」ではなく、採用理由を1行で残す

ここまでなら、反対派も賛成派も折り合いやすいラインです。ルールを増やしたくなったら、まずは運用で困った“実例”が出てから追加します。先に作り込むほど守られません。

仕組み化のコツ:PRテンプレに埋める(人に頼らない)

標準化で一番効くのは、「意識」ではなく「デフォルト」にすることです。個人の注意力に頼ると続きません。GitHub/GitLabのPRテンプレに以下を入れるだけで、効果が出やすくなります。

PRテンプレ例(コピペ用)

目的(KPI)

- 何を改善する変更か:例)リードタイム短縮 / 障害率低下 / 問い合わせ削減

- 成功指標(任意):例)手戻り件数、失敗率、MTTR など

生成AIの利用(任意)

- 使った/使ってない:

- 使った場合:どの工程(要約/下書き/テスト観点/レビュー観点):

採用前チェック(必須)

- [ ] 要件一致(受け入れ条件に合う)

- [ ] 境界条件(null/空/上限下限/例外/並行など)

- [ ] セキュリティ(入力検証/権限/秘密情報/ログ)

補足

- 採用理由(1行でOK):

- リスクとガードレール(あれば):

ポイントは、ChatGPTを使ったかどうかを問い詰めることではなく、品質と説明責任のチェックを“標準”にすることです。使った人だけが追加で責められる構造にすると反発が起きるので、「使っても使わなくても、品質チェックは同じ」という設計が重要です。

合意形成の進め方:会議で勝たず、実験で納得を作る

「生成AIを導入したい」と言うと、議論が理念戦になりがちです。ここで評価される動き方は、正論で押し切ることではなく、小さな実験で納得を作ることです。

- 提案の形:「まず2週間、事故りにくい用途だけで試して、レビュー指摘と手戻りが減るか見ませんか」

- 測る指標:レビュー指摘件数、再発指摘率、手戻り件数、PRの滞留時間

- やめどき:「悪化したら撤回」もセットで言う(心理的安全性が上がる)

このやり方だと、反対派も「データで判断しよう」に乗りやすくなります。さらに、効果が出たときに評価されるのは、ChatGPTを上手く使った人ではなく、実験設計してチームを前に進めた人です。

NG集:評価を落とす“標準化の失敗パターン”

最後に、やりがちな失敗をあえて明確にします。これを避けるだけで、導入の成功率が上がります。

- NG1:いきなり全面義務化(反発が起き、形骸化して終わる)

- NG2:ルールを作り過ぎる(読まれない・守られない・運用されない)

- NG3:使った人を責める構造(隠れて使うようになり、リスクが増える)

- NG4:成果を測らない(“便利そう”で終わり、投資扱いされない)

- NG5:セキュリティを曖昧にする(最終的に禁止に倒れやすい)

標準化のゴールは、ChatGPTを導入することではなく、「品質と説明責任を落とさずにスピードを上げる」ことです。ここまで整うと、ChatGPTを使えるだけの人ではなく、ChatGPTを“組織の成果に変換できる人”として評価されます。

KPI提案:チーム標準化を“評価される成果”にするKPI

- KPI1:PRテンプレ遵守率:チェック欄が埋まっているPRの割合(まず80%を目標)

- KPI2:再発指摘率:同種指摘の再発回数を月次で減らす(カテゴリ別に可視化)

- KPI3:PR滞留時間:レビュー待ち時間の中央値を下げる(論点が揃うと改善しやすい)

これらは“個人のAIスキル”ではなく、“チームの再現性を上げた成果”として説明できるため、評価に直結しやすい指標です。

セクション5:評価に直結するアウトプットの作り方――「実績の見せ方」と「転職での語り方」で差がつく

ここまでで見えてきた通り、「ChatGPTを使える」だけでは評価が上がりません。評価されるのは、ChatGPTを“成果の拡張装置”として使い、品質・説明責任・運用を落とさずにチームへスケールさせられる人です。最後のセクションでは、その力を評価に直結するアウトプットとして形にする方法と、転職市場でも伝わる語り方(面接・職務経歴書)に落とし込みます。

アウトプットは「コード」より「判断と再現性」が見える形にする

生成AI時代に強いアウトプットは、単なる成果物(コード)よりも「なぜそう判断したか」「どう品質を担保したか」「運用でどう改善したか」が見えるものです。なぜなら、実装の速度は生成AIで均されやすく、差は判断と運用に移るからです。評価者に刺さる成果物は、次の3種類に収れんします。

- 意思決定ログ(ADR/設計メモ):採用理由・代替案・リスク・ガードレールが3〜5行で残っている

- 品質資産(テスト観点集/レビュー観点テンプレ):抜けやすい境界条件・セキュリティ観点がテンプレ化されている

- 運用資産(監視項目/Runbook/改善ログ):障害時に追える、改善ループが回っている証拠がある

これらは「個人の時短」ではなく「チームの時間を守った」証拠になります。結果として、“任せられる人”として評価されやすくなります。

実績の作り方:ChatGPT活用は「成果KPI」とセットで語る

評価につながる語り方のコツは、ChatGPTを主語にしないことです。主語は常に「課題」と「成果」に置きます。ChatGPTは“手段”として一文で添える程度で十分です。おすすめは、次の順番です。

- 課題:何が問題だったか(例:リードタイムが長い、レビューが詰まる、バグが再発する)

- 仮説:何を変えれば改善するか(例:定義テンプレとテスト観点を先に固める)

- 施策:何を導入したか(例:PRテンプレ、チェック3点、ADRの軽量運用)

- 成果:何がどう良くなったか(数値)

- 再現性:チームに残した資産(テンプレ/ガイド/Runbook)

この構造で話せると、「ChatGPTを使える人」ではなく「成果を出し続ける人」に見えます。

テンプレ:職務経歴書・面接で使える“成果の書き方”

以下はそのまま転用できる型です(社内実績でも転職でも同じ)。

- プロジェクト:〇〇(期間:〇ヶ月)

- 課題:〇〇が原因で△△が発生(例:手戻り増、レビュー滞留、障害再発)

- 施策:要件定義テンプレ+テスト観点テンプレ+PRテンプレ(チェック3点)を整備し、生成AIは下書き生成と観点抽出に限定して活用

- 成果(KPI):レビュー指摘再発率を〇%削減/PR滞留時間中央値を〇日短縮/障害件数を〇件→〇件

- 再現性:ADR運用、テスト観点集、Runbookを資産化しオンボーディング工数を削減

「生成AIを使った」よりも、「品質と速度を両立し、チームに再現性を残した」が伝わるため評価されやすくなります。

社内で評価される“見せ方”:上司/評価者に刺さる報告は1枚でいい

社内評価で差がつくのは、成果が見えない状態を放置しないことです。月次で1枚の報告(箇条書きでOK)を出せると、評価者が判断しやすくなります。内容は次の3点だけで十分です。

- 今月の改善:何を標準化/仕組み化したか(テンプレ、チェック、運用)

- 数字:再発指摘率、PR滞留時間、手戻り件数、障害件数などから1〜2個

- 次月の打ち手:改善ループの次の一手(例:境界条件のテスト強化、監視項目の追加)

ChatGPTを使っていること自体は報告の主役にしません。主役は「改善」と「数字」です。

KPI提案:評価に直結する“最小KPIセット”

最後に、日々の行動が評価に直結するよう、運用しやすいKPIを3つに絞ります。これなら忙しくても回せます。

- KPI1(品質):レビュー指摘の再発率(同じ指摘が次のPRでも出たら再発)を月次で減らす

- KPI2(説明責任):重要PRのADR添付率(3〜5行)を上げる(まず50%→80%)

- KPI3(スケール):月2本、チームに残る資産(テンプレ/観点集/Runbook)を追加する

この3つが回り始めると、「ChatGPTを使えるだけ」の評価から、「ChatGPTを使ってチームの成果を安定させる」評価に変わります。

明日からできる3アクション

- アクション1:PRテンプレに「要件一致/境界条件/セキュリティ」の3点チェック欄を追加し、毎PRで埋める

- アクション2:重要PRだけでいいので、3〜5行のADR(採用理由・代替案・リスク・ガードレール)を残す

- アクション3:テスト観点テンプレかレビュー観点テンプレを1つ作り、チームに共有して“再現性の資産”にする

転職やキャリア選択の解像度を上げたい場合は、こちらも参考にしてください。