生成AIの普及で「エンジニアの市場価値は上がる人と下がる人が二極化する」と言われるようになりました。実際、AI関連求人は拡大しており、AIに関わる求人は2017年度比でエンジニア系職種が約6.6倍というデータも出ています。[出典:インディードリクルートパートナーズ 2025年7月24日]

一方で、生成AIに“仕事を奪われる”のではなく、生成AIで「生産性が上がる前提の働き方」に適応できない人から相対的に評価が落ちるのが現実です。この記事では「生成AI エンジニア 市場価値」を軸に、市場価値が下がりやすい特徴と、今日から取れる具体策・KPIを、実務で使えるレベルに落とし込みます。

生成AIで市場価値が下がるのは「技術力不足」より「仕事の定義ズレ」

生成AI時代の市場価値低下は、単純に「コードが書けない」では説明できません。むしろ、仕事の定義が変わる中で“価値が出るポイント”を取り違えることが原因になりやすいです。世界経済フォーラムは、2030年までに労働市場で求められる主要スキルのうち39%が変化すると示しており、継続学習・リスキリングの重要性が強調されています。[出典:WEF Future of Jobs Report 2025(2025年1月)]

また経済産業省は、生成AI時代のDX推進人材に「問いを立てる力」「仮説を立て・検証する力」「評価する・選択する力」が求められると整理しています。これはエンジニアでも同じで、単に実装するだけでなく、何を作るべきか・何を捨てるべきかを判断できる人が強くなります。[出典:経産省「生成AI時代のDX推進に必要な人材・スキルの考え方2024(概要)」]

実例:同じ“AI活用”でも評価が分かれたケース

たとえば社内に「生成AIでコーディングを速くする」取り組みが入ったとき、Aさんは“生成AIに丸投げして動いたらOK”で進め、レビューでバグ・仕様漏れが増えました。一方Bさんは、要件→リスク→テスト観点を先に整理し、生成AIを「下書き生成」と「抜け漏れ検知」に使い分け、リードタイム短縮と品質維持を両立。結果、同じ実装量でもBさんの評価が上がりました(※個人が特定されないよう一部改変)。

KPI提案:価値ズレを防ぐ“判断の可視化”

- 毎週1回「生成AIを使った成果」を1行で記録(例:実装時間30%短縮、障害0件)

- 設計・判断に関するアウトプットを週1本残す(ADR、設計メモ、テスト観点など)

- 生成AIの出力を採用する前に“根拠チェック”を必ず3点(要件一致、境界条件、セキュリティ)

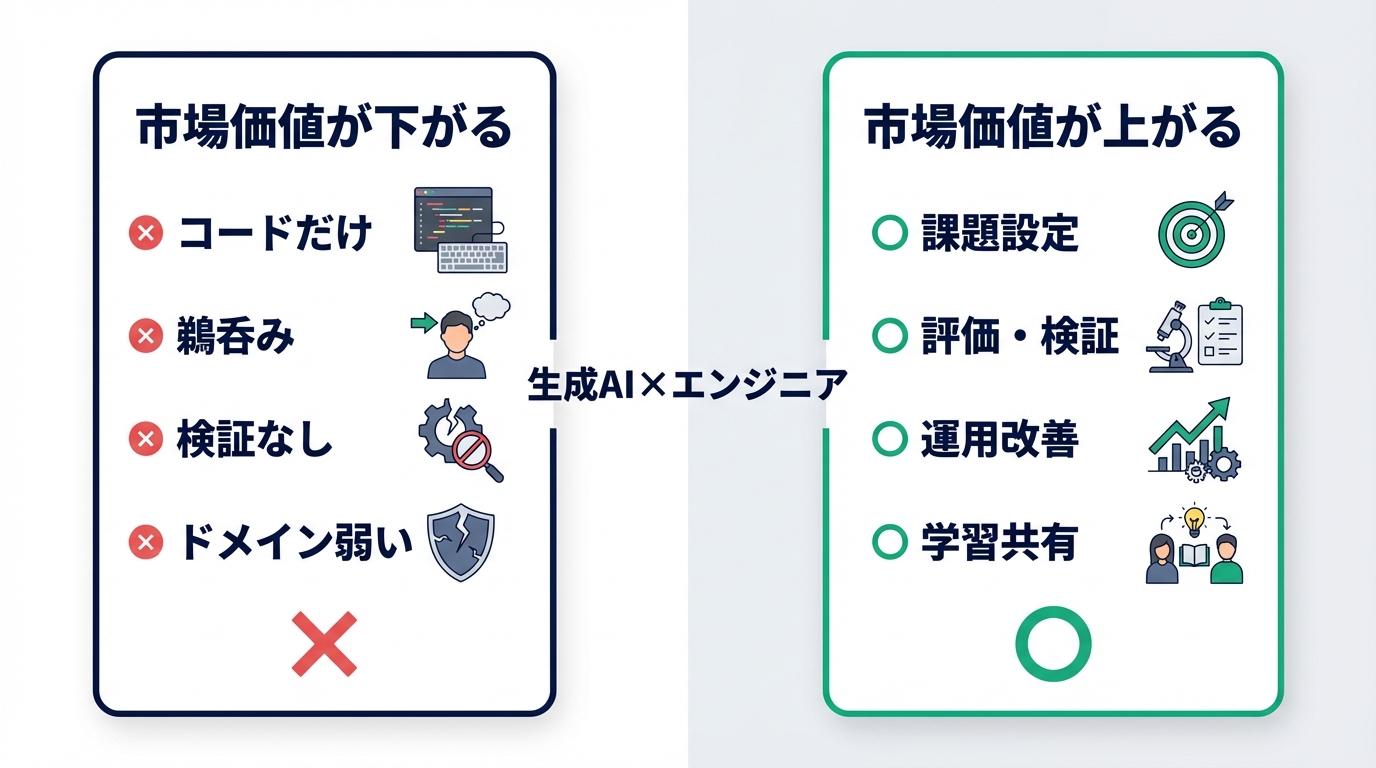

市場価値が下がるエンジニアの特徴7つ

AI関連求人が増える局面でも、市場価値が下がる人は一定数出ます。背景には「AIが価値を生む領域が広がり、同じ時間で生み出せる成果の基準が上がる」ことがあります。マッキンゼーは生成AIが労働生産性を押し上げ得るとし、採用側が“生産性前提の働き方”を求める流れを後押ししています。[出典:McKinsey “The economic potential of generative AI”]

特徴1〜3:作業者ポジション固定(言われた実装だけ/目的不在/品質を説明できない)

特徴1:言われた実装だけで価値を作る(課題の再定義ができない)

特徴2:目的より手段が先(新技術導入がゴール)

特徴3:品質を言語化できない(テスト戦略・SLO・リスク説明が弱い)

実例:「生成AIで爆速開発」を掲げたチームで、タスク消化が速い人より、要件の穴を先に埋めて手戻りを減らす人が評価され、昇格したケースは珍しくありません。

KPI提案:

- 週次で「手戻り件数」「レビュー指摘件数」をトラッキングし、改善施策を1つ打つ

- 要件確認の質問を毎案件3つ以上投げる(曖昧さの削減)

特徴4〜7:AIを“使えない/使わない”より危険な4タイプ

特徴4:AIの出力を鵜呑みにする(検証せずに採用)

特徴5:プロンプトだけ上手くて実務に繋がらない(評価指標がない)

特徴6:学びが点在して体系化できない(再現性がない)

特徴7:ドメイン理解が浅い(業務の制約・法務・運用を知らない)

実例:生成AI導入プロジェクトで、PoCは早いが本番運用で事故が増える人と、「評価指標(正確性/再現性/コスト)を決めて改善ループを回せる人」で、信頼と裁量が大きく分かれます。

KPI提案:

- 生成AI利用の“評価指標”を必ず設定(例:正答率、再現率、レビュー修正率、コスト/1件)

- 週1で「学んだこと→チームに共有」1本(Notion/社内Wiki)

市場価値を上げるエンジニアがやっている“3つのレイヤー”

市場価値を上げる鍵は、生成AIを「道具」として使いながら、価値の出どころを上流(課題設定)と下流(運用・改善)に広げることです。経産省が示すように、生成AI時代は“問い・仮説検証・評価と選択”が重要になります。[出典:経産省 2024]

レイヤー1:課題設定(問いを立てる)レイヤーを持つ

強い人は「何を作るか」ではなく「何を解くか」から入ります。要件を分解し、価値指標(売上、CV、稼働削減、障害率)に繋げて設計できると、AIが実装を速めても価値は下がりません。

実例:同じチャットボットでも、FAQ置き換えで終わる人と、問い合わせ分類・有人エスカレーション・学習データ改善まで設計して“コスト削減KPI”を達成する人で、評価が変わります。

KPI提案:

- 毎案件「価値指標を1つ」決めて合意(例:応答時間、問い合わせ削減率)

- 要件を「Must/Should/Could」で仕分けし、捨てる判断を明文化

レイヤー2:検証と評価(AIの品質を担保する)レイヤーを持つ

生成AIは便利ですが、出力の正確性・偏り・再現性が課題になります。だからこそ、評価設計(テストセット、観点、監視)を持てる人は強いです。これはLLMに限らず、ソフトウェア品質の延長線にあります。

実例:「プロンプト改善」だけでなく、失敗例の収集→評価データ更新→ガードレール設計(禁止ワード、参照元明示)まで回すと、プロダクトとして成立しやすくなります。

KPI提案:

- 評価用のテストケースを最低30件作成し、週次で更新

- リリース後の「誤回答率」「手戻り率」をモニタし、改善サイクルを回す

90日で差がつく:生成AI時代のキャリアKPIと実行ロードマップ

「何を学べばいいか分からない」状態を抜けるには、期間を切ってKPIで進めるのが最短です。スキル変化が加速する中、継続的な学びが重要だという指摘は国際レポートでも繰り返されています。[出典:WEF 2025]

0〜30日:業務に生成AIを“安全に組み込む”

- KPI:週3回、生成AI活用で短縮できた時間を記録(合計3時間以上を目標)

- KPI:AI出力の検証チェックリストを作り、毎回適用(3項目固定)

- 成果物:自分用の「プロンプト&レビュー観点集」

実例:まずは議事録整理、テストケース草案、コードレビューの観点抽出など“事故りにくい領域”から入ると定着が早いです。

31〜60日:設計・評価のアウトプットを作る

- KPI:ADR/設計メモを月2本公開(社内Wikiでも可)

- KPI:レビューでの指摘再発率を20%下げる(観点の仕組み化)

- 成果物:小さな改善を1本リリース(監視・テスト自動化・運用改善でもOK)

実例:AI活用より「判断と品質の再現性」を見せられると、評価が上がりやすいです。

61〜90日:プロダクト価値に直結する「運用・改善ループ」を回す

61日目以降は「AIを使える」「設計できる」だけで終わらせず、運用で価値を出し続ける人に寄せます。生成AIは導入よりも、リリース後の改善(評価データ更新、ガードレール、監視、コスト最適化)で差がつくためです。世界経済フォーラムもスキル変化の加速と継続的な学びの重要性を示しており、学習を成果に結び付ける“改善サイクル”が競争力になります。[出典:WEF Future of Jobs Report 2025]

- KPI:生成AI利用機能(またはAI支援プロセス)の品質指標を1つ置き、週次で改善(例:誤回答率、レビュー修正率、手戻り率、障害件数)

- KPI:運用KPIを1つ置き、週次で改善(例:応答時間、問い合わせ削減率、開発リードタイム、MTTR、SLO達成率)

- KPI:コスト最適化の指標を1つ置く(例:1リクエストあたりコスト、トークン消費量、キャッシュヒット率)

- 成果物:「評価→改善→再評価」を回した証拠として、週次レポート(1枚)か改善ログ(Notion/社内Wiki)を4回分残す

- 成果物:チームに共有できる「ガードレール設計」(禁止パターン、例外処理、参照元明示、権限・監査)を1つ作る

実例:社内の生成AI活用で、最初は「プロンプトの工夫」で精度が上がっても、運用が始まると“誤回答の再発”や“想定外入力”が増えがちです。ここで、失敗例を収集→評価データに反映→ガードレール追加→監視強化、というループを回せる人は「任せられる人」になり、役割と市場価値が上がりやすくなります(※個人が特定されないよう一部改変)。

行動チェック(61〜90日の型):迷ったらこの順で固定すると早いです。

- ① 失敗例を10件集める(ログ/レビュー指摘/問い合わせ)

- ② 失敗を3分類する(要件不一致/境界条件/セキュリティ・ガバナンス)

- ③ 予防策を1つ実装する(テストケース追加、入力制限、参照元表示、監視アラート)

- ④ 1週間後にKPIで効果測定し、次の失敗へ回す

まとめ:下がる特徴を避ければ、市場価値は“守る”から“上げる”へ変えられる

生成AI時代に市場価値が下がるのは、技術が足りないというより「価値の出る場所」を見誤ることが原因になりがちです。AI関連求人が伸びるほど、実装スピードは前提になり、課題設定・評価・運用まで含めて価値を出せる人が強くなります。[出典:インディードリクルートパートナーズ 2025 / WEF 2025 / 経産省 2024]

明日からできる3アクション

- アクション1:今の業務で「AIに任せる部分」と「自分が判断する部分」を分け、判断ログを残す

- アクション2:生成AIの出力を採用する前に、検証チェック(要件一致/境界条件/セキュリティ)を固定化する

- アクション3:30日で1つ、設計・評価・運用のアウトプット(ADR/テスト観点/監視)を公開する

【参考】

[出典:インディードリクルートパートナーズ「AI関連求人は2017年度比で約6.6倍に拡大」(2025年7月24日)]

[出典:世界経済フォーラム The Future of Jobs Report 2025(2025年1月)]

[出典:経済産業省「生成AI時代のDX推進に必要な人材・スキルの考え方2024(概要)」(2024年6月28日)]

[出典:McKinsey “The economic potential of generative AI”]